«Пройти между Сциллой и Харибдой»: российский специалист — о проблемах правового и этического регулирования ИИ

Законотворчество пока отстаёт от темпов развития технологий машинного обучения. Законодателям всех стран только предстоит выработать правовые нормы, которые будут регулировать сферу искусственного интеллекта. Однако уже сейчас эти технологии порождают правовые и этические коллизии — например, кто понесёт ответственность при ДТП с участием беспилотного автомобиля, может ли человек запретить собирать данные о его действиях в цифровой среде и т. д. Об этом в интервью RT рассказала заведующая кафедрой философии образования философского факультета МГУ, руководитель магистерской программы «Биоэтика», доцент, кандидат философских наук Елена Брызгалина. По её мнению, для регулирования ИИ необходимо формировать такой же механизм этической экспертизы, какой действует сегодня в биомедицинской сфере.

— Главное отличие искусственного интеллекта от других технологий заключается в его способности обучаться, прежде это было прерогативой лишь биологических существ. И при этом ИИ способен очень быстро обрабатывать огромные объёмы информации.

Судя по тому спектру задач, решить которые способен ИИ, эта технология действительно является основой для нового этапа научно-технического прогресса. Прежде всего, ИИ направлен на решение задач автоматизации рутинных операций, его применение повышает эффективность работы.

И кроме того, сегодня есть надежда на то, что ИИ позволит также улучшить качество принимаемых решений, нейросети зачастую могут найти взаимосвязи в огромных массивах данных, проанализировать которые не под силу человеку. Как и любая другая технология, это обоюдоострое оружие, пока последствия внедрения ИИ не до конца понятны.

Поэтому законотворчество отстаёт от темпов развития технологий, сейчас даже нет определённости относительно того, нужно ли регулирование ИИ выделять в отдельный свод правил, или же на эту сферу следует распространить ряд общих правовых и этических норм.

— Пока единой позиции по этому вопросу в юридическом сообществе нет. Илон Маск проводил аналогию между автомобилями с автопилотом и лифтами — если лифт ломается, то никто не предъявляет иски к его производителю. Претензии предъявляются к установщикам лифта и компании, которая его обслуживает. При этом шведский автоконцерн Volvo заявил, что берёт на себя всю ответственность за ДТП с участием беспилотников.

Но понятно, что в любом случае беспилотные технологии находятся в зоне особого риска, особенно учитывая вероятность хакерской атаки на такую систему. Пока единых правил нет, они только формируются, но в целом есть тенденция к детальному расследованию каждой такой аварии.

— Серьёзные юридические споры вызывает вопрос авторского права в связи с ИИ. Например, недавно на компанию-разработчика ChatGPT подали в суд писатели, среди них Джордж Мартин, поскольку их книги использовались для обучения нейросети. При этом часто звучит аргумент, что и человеку для создания книги или картины нужен культурный базис, ознакомление с произведениями великих авторов. Как должна быть разрешена данная правовая коллизия? И кому принадлежат авторские права на созданное нейросетью изображение?

— Когда мы оцениваем любой артефакт на предмет того, искусство перед нами или нет, мы во многом ориентируемся на то, какие цели преследовал автор. Генеративные нейросети могут создавать оригинальные объекты, но в соавторстве с человеком. Поэтому здесь уместно говорить об авторском «коллективе». Источником эмоционального переосмысления мира, источником смыслов, которые предопределяют визуализацию, например или словесный образ, является всё равно человек. А у ИИ нет собственного намерения что-то донести до зрителя или читателя, это просто инструмент. Соответственно, инструмент не может быть субъектом права или нарушения авторских прав.

— А в случае генерации дипфейков и в целом ложной информации, здесь ответственность уже на распространителе этого контента?

— Да, если он не укажет специально, что это дипфейк, будет выдавать фейк за подлинное видео или реальную новость.

— В России идея «социального рейтинга» вызывает у многих людей отторжение. В то же время, социальный и даже психологический скоринг на основе цифрового следа — одна из сфер применения ИИ. Допустимо ли такое с этической и правовой точки зрения? Можно ли приравнять это к слежке за человеком?

— Можно рассмотреть этот вопрос на примере системы образования. В современном динамичном мире человек должен учиться постоянно, речь идёт не только о формальном образовании, но также о самообразовании, различных курсах и т. д. ИИ может помочь выстроить индивидуальную образовательную траекторию человека, а также сформировать его образовательный «портрет». В России с 2021 года уже применяется верифицированное портфолио абитуриента — сервис, где в цифровом виде суммированы учебные, спортивные, творческие достижения за период обучения в школе.

А кроме того, беспокоит социальная дифференциация, это тоже опасный момент. Например, когда осуществляется массовая стандартизированная оценка, мы видим, как выглядят образовательные результаты относительно других учеников, студентов и т. д. А нейросеть будет оценивать человека в отрыве от социального контекста. И в перспективе такой подход может привести к распаду целостности общества. Ещё у Платона был образ — пещера, где люди видят лишь тени предметов на стене, но не могут выйти из неё и увидеть реальный мир. Образ платоновской пещеры применительно к цифровой культуре использовал в своё время покойный Владимир Васильевич Миронов, декан философского факультета.

Ещё одна проблема — будет ли человек в такой системе иметь открытое будущее, или оно будет полностью детерминировано его прошлыми поступками и результатами?

Кроме того, ИИ меняет методы решения и психологических, и социологических задач, он позволяет перейти от практики задавания вопросов к попыткам увидеть за стандартными действиями человека его реальные мысли и желания. Пока что это имеет относительно безобидное проявление в виде таргетированной рекламы, но по мере роста числа маркеров, по которым будет отслеживаться человеческое поведение, глубина этого мониторинга будет нарастать. И это сделает людей более уязвимыми для пропаганды, перед различного рода манипуляциями — поскольку каждому можно будет подавать информацию индивидуально, с расчётом на его особенности восприятия. И в таких условиях уровень критичности восприятия информации будет падать. Так что здесь просматривается очень много рисков.

— Все зависит от того, как трактовать золотой стандарт этики — обязательность получения добровольного информированного согласия человека на любые манипуляции с ним. Добровольность означает отсутствие принуждения, обмана и давления. Люди добровольно используют интернет и нейросети, их никто не принуждает. Что касается информированности, то людям в целом также давно известно, что их действия в цифровом пространстве отслеживаются. Остаётся определиться с тем, какая степень информированности человека гарантирует полную добровольность в данном случае. Если человек плохо информирован, можно ли его действия трактовать как добровольный выбор?

И тут можно провести аналогию с научными экспериментами, например психологическими, участникам которых также не даётся полная информация о сути предстоящих испытаний. Эти люди просто знают, что принимают участие в эксперименте. Так и здесь, погружаясь в цифровую среду, мы фактически соглашаемся стать участниками большого эксперимента. Просто людям нужно время, чтобы осознать степень их вовлечённости в технологии цифрового отслеживания.

— В нашумевшем сериале «Чёрное зеркало» одна из серий была посвящена истории вдовы, которая купила «цифрового двойника» своего покойного мужа — в робота были загружены все записи супруга в соцсетях, дневниках и т. п., нейросеть генерировала речь на основе этого контента. Сегодня эта технология уже применяется, можно заказать создание цифрового «аватара» себя или другого человека. Насколько это этично?

— Есть мнение, что технологии виртуальной реальности можно использовать для помощи людям, переживающим посттравматические расстройства. Например, такой эксперимент проводили в Южной Корее, когда потерявшей дочь матери устроили «встречу» с виртуальным аватаром ребёнка. Возможно, эта процедура стала для этой женщины ещё одним элементом переживания утраты. Вопрос в том, ослабит это боль утраты или, напротив, усилит? Это очень индивидуально. Плюс, нужно учитывать культурные особенности — например, в Корее совсем другие траурные традиции, чем в России. Конфуцианская традиция подразумевает активное «общение» с духами покойных родственников, чего у нас нет. И новые технологии часто просто предлагают какие-то аналоги уже имеющихся в культурной традиции проявлений. Поэтому с этической точки зрения, прежде всего, такие вещи должны создаваться индивидуально под конкретных людей, а не просто для развлечения.

— Феномен антропоморфизации нейросетей людьми, появился давно — такие эмоции вызывала ещё созданная в 1966 году программа «Элиза», которая была предназначена для психотерапии. Какие социальные последствия может иметь такое очеловечивание нейросетей?

— Дело в том, что пока даже специалисты не смогли договориться, что же такое сознание и разум — ни психологи, ни философы. Поэтому люди руководствуются в этом вопросе бытовыми представлениями — если программа рисует и пишет подобно человеку, то, значит, она на него похожа. В 2013 году на эту тему вышел хороший фильм «Она», где главный герой полюбил операционную систему, искусственный интеллект, который «общался» женским голосом.

Это хорошая иллюстрация того, как люди могут впасть в зависимость от ИИ. Тем более, что все коммерческие продукты создаются с расчётом на то, чтобы пользователи проводили с ними как можно больше времени. В современном мире идёт ожесточённая борьба за внимание людей, чем дольше вы сидите в определённой соцсети, тем больше рекламы она может вам показать и заработать. И когда создаются антропоморфные машины, которые имитируют человеческие проявления, нам трудно сопротивляться — так устроена наша психика. Такие программные продукты вызывают у человека ложное чувство замены традиционных социальных связей. Однако пока мы это отслеживаем, а смогут ли отслеживать границу между суррогатной и реальной социализацией новые поколения — это вопрос.

— Говоря об ИИ, сложно не затронуть тему вооружений: нейросети всё активней применяются в ударных дронах и других видах оружия всеми странами. Какие этические проблемы есть в связи с этим?

— Самая обсуждаемая в этом контексте тема — беспилотные летальные вооружения, именно это вызывает наибольшие опасения. Это не просто автоматизация действий, которыми управляет человек. Это ситуация, когда автономные устройства не зависят от человека в выборе цели и сами принимают решение о нанесении удара, что ставит очень много серьёзных вопросов. Очень важно, чтобы появилось правовое регулирование этой области. При правильном применении автономные вооружения могли бы минимизировать число жертв среди участников конфликта и мирного населения, так что это тоже медаль с двумя сторонами. Есть позиция, согласно которой мы не должны исключать человека из процедур принятия моральных решений, а нанесение удара — это как раз моральный выбор. На мой взгляд, в отношении такого оружия всё же должна возобладать запретительная правовая тенденция.

— Как и в случае многих других технологий, с ИИ нам нужно суметь пройти между Сциллой и Харибдой. Чтобы, с одной стороны, чрезмерным контролем и бюрократией не затормозить исследования в этой области. А с другой — минимизировать риски, которые влечёт бесконтрольное внедрение некоторых технологий. В этом и заключается цель и смысл правового и этического регулирования. Те примеры, которые мы с вами разобрали, говорят о том, что вряд ли возможно выработать универсальные правила для всей цифровой отрасли, без учёта конкретной специфики. В каждом конкретном случае необходима тщательная этическая экспертиза, как это уже работает в области биомедицинских исследований. Каждое медицинское исследование получает одобрение этического комитета учебного учреждения, в случае с ИИ нам нужно выстроить похожий механизм социально-гуманитарной экспертизы.

Gettyimages.ru © nanami_o

— Искусственный интеллект применяется всё шире, и правовое регулирование не успевает за скоростью развития технологии — об этом вы говорили недавно в своём выступлении во время «Научного кафе», организованного Фондом Андрея Мельниченко. В чём принципиальные особенности ИИ, которые диктуют необходимость вырабатывать отдельные законы и правила?— Главное отличие искусственного интеллекта от других технологий заключается в его способности обучаться, прежде это было прерогативой лишь биологических существ. И при этом ИИ способен очень быстро обрабатывать огромные объёмы информации.

Судя по тому спектру задач, решить которые способен ИИ, эта технология действительно является основой для нового этапа научно-технического прогресса. Прежде всего, ИИ направлен на решение задач автоматизации рутинных операций, его применение повышает эффективность работы.

И кроме того, сегодня есть надежда на то, что ИИ позволит также улучшить качество принимаемых решений, нейросети зачастую могут найти взаимосвязи в огромных массивах данных, проанализировать которые не под силу человеку. Как и любая другая технология, это обоюдоострое оружие, пока последствия внедрения ИИ не до конца понятны.

Поэтому законотворчество отстаёт от темпов развития технологий, сейчас даже нет определённости относительно того, нужно ли регулирование ИИ выделять в отдельный свод правил, или же на эту сферу следует распространить ряд общих правовых и этических норм.

Автомобиль Tesla globallookpress.com © Keystone Press Agency / Cfoto

— В 2018 году в США разгорелся скандал — управляемый автопилотом автомобиль «Тесла» попал в аварию, его владелец погиб. Родственники обвинили компанию-производителя в трагедии, однако в «Тесла» отказались выплачивать компенсацию, заявив, что водитель должен был всё же следить за дорогой. Когда будет выработан правовой консенсус, как должны разрешаться подобные споры?— Пока единой позиции по этому вопросу в юридическом сообществе нет. Илон Маск проводил аналогию между автомобилями с автопилотом и лифтами — если лифт ломается, то никто не предъявляет иски к его производителю. Претензии предъявляются к установщикам лифта и компании, которая его обслуживает. При этом шведский автоконцерн Volvo заявил, что берёт на себя всю ответственность за ДТП с участием беспилотников.

Но понятно, что в любом случае беспилотные технологии находятся в зоне особого риска, особенно учитывая вероятность хакерской атаки на такую систему. Пока единых правил нет, они только формируются, но в целом есть тенденция к детальному расследованию каждой такой аварии.

— Серьёзные юридические споры вызывает вопрос авторского права в связи с ИИ. Например, недавно на компанию-разработчика ChatGPT подали в суд писатели, среди них Джордж Мартин, поскольку их книги использовались для обучения нейросети. При этом часто звучит аргумент, что и человеку для создания книги или картины нужен культурный базис, ознакомление с произведениями великих авторов. Как должна быть разрешена данная правовая коллизия? И кому принадлежат авторские права на созданное нейросетью изображение?

— Когда мы оцениваем любой артефакт на предмет того, искусство перед нами или нет, мы во многом ориентируемся на то, какие цели преследовал автор. Генеративные нейросети могут создавать оригинальные объекты, но в соавторстве с человеком. Поэтому здесь уместно говорить об авторском «коллективе». Источником эмоционального переосмысления мира, источником смыслов, которые предопределяют визуализацию, например или словесный образ, является всё равно человек. А у ИИ нет собственного намерения что-то донести до зрителя или читателя, это просто инструмент. Соответственно, инструмент не может быть субъектом права или нарушения авторских прав.

Нейросеть — генератор картинок Gettyimages.ru © CentralITAlliance

Например, мы хотим приписать авторство и соответствующие права нейросети компьютерной программе. Однако, согласно Гражданскому кодексу РФ, автором может быть только человек. То есть, формально ответ на вопрос уже есть. Однако нужно ещё разобраться, какие люди являются владельцами прав на созданные нейросетью изображений, музыки и текстов — создатели компьютерной программы или пользователи, которые используют её как инструмент? Ответа на этот вопрос нет, а ведь использование сгенерированных объектов может приносить прибыль — кому она должна принадлежать? Юридической ясности в этой области нет, поэтому я и говорю, что правовая сфера серьёзно отстаёт от темпов развития новых технологий машинного обучения.— А в случае генерации дипфейков и в целом ложной информации, здесь ответственность уже на распространителе этого контента?

— Да, если он не укажет специально, что это дипфейк, будет выдавать фейк за подлинное видео или реальную новость.

— В России идея «социального рейтинга» вызывает у многих людей отторжение. В то же время, социальный и даже психологический скоринг на основе цифрового следа — одна из сфер применения ИИ. Допустимо ли такое с этической и правовой точки зрения? Можно ли приравнять это к слежке за человеком?

— Можно рассмотреть этот вопрос на примере системы образования. В современном динамичном мире человек должен учиться постоянно, речь идёт не только о формальном образовании, но также о самообразовании, различных курсах и т. д. ИИ может помочь выстроить индивидуальную образовательную траекторию человека, а также сформировать его образовательный «портрет». В России с 2021 года уже применяется верифицированное портфолио абитуриента — сервис, где в цифровом виде суммированы учебные, спортивные, творческие достижения за период обучения в школе.

Студенты в аудитории Gettyimages.ru © skynesher

Проблема в том, что критерии оценки ИИ в ряде случаев очень непрозрачные, оцениваемый нейросетью человек не может спросить, почему она решила так, а не иначе. Это, разумеется, беспокоит людей.А кроме того, беспокоит социальная дифференциация, это тоже опасный момент. Например, когда осуществляется массовая стандартизированная оценка, мы видим, как выглядят образовательные результаты относительно других учеников, студентов и т. д. А нейросеть будет оценивать человека в отрыве от социального контекста. И в перспективе такой подход может привести к распаду целостности общества. Ещё у Платона был образ — пещера, где люди видят лишь тени предметов на стене, но не могут выйти из неё и увидеть реальный мир. Образ платоновской пещеры применительно к цифровой культуре использовал в своё время покойный Владимир Васильевич Миронов, декан философского факультета.

Ещё одна проблема — будет ли человек в такой системе иметь открытое будущее, или оно будет полностью детерминировано его прошлыми поступками и результатами?

Кроме того, ИИ меняет методы решения и психологических, и социологических задач, он позволяет перейти от практики задавания вопросов к попыткам увидеть за стандартными действиями человека его реальные мысли и желания. Пока что это имеет относительно безобидное проявление в виде таргетированной рекламы, но по мере роста числа маркеров, по которым будет отслеживаться человеческое поведение, глубина этого мониторинга будет нарастать. И это сделает людей более уязвимыми для пропаганды, перед различного рода манипуляциями — поскольку каждому можно будет подавать информацию индивидуально, с расчётом на его особенности восприятия. И в таких условиях уровень критичности восприятия информации будет падать. Так что здесь просматривается очень много рисков.

Цифровой след человека Gettyimages.ru © Jackie Niam

— Сейчас всюду много говорят о «больших данных» как о ценном ресурсе. Утверждается, будто эти данные собираются, а затем перепродаются и обрабатываются уже в обезличенном виде. Должен ли человек иметь право исключить свои данные из этого «оборота»?— Все зависит от того, как трактовать золотой стандарт этики — обязательность получения добровольного информированного согласия человека на любые манипуляции с ним. Добровольность означает отсутствие принуждения, обмана и давления. Люди добровольно используют интернет и нейросети, их никто не принуждает. Что касается информированности, то людям в целом также давно известно, что их действия в цифровом пространстве отслеживаются. Остаётся определиться с тем, какая степень информированности человека гарантирует полную добровольность в данном случае. Если человек плохо информирован, можно ли его действия трактовать как добровольный выбор?

И тут можно провести аналогию с научными экспериментами, например психологическими, участникам которых также не даётся полная информация о сути предстоящих испытаний. Эти люди просто знают, что принимают участие в эксперименте. Так и здесь, погружаясь в цифровую среду, мы фактически соглашаемся стать участниками большого эксперимента. Просто людям нужно время, чтобы осознать степень их вовлечённости в технологии цифрового отслеживания.

— В нашумевшем сериале «Чёрное зеркало» одна из серий была посвящена истории вдовы, которая купила «цифрового двойника» своего покойного мужа — в робота были загружены все записи супруга в соцсетях, дневниках и т. п., нейросеть генерировала речь на основе этого контента. Сегодня эта технология уже применяется, можно заказать создание цифрового «аватара» себя или другого человека. Насколько это этично?

— Есть мнение, что технологии виртуальной реальности можно использовать для помощи людям, переживающим посттравматические расстройства. Например, такой эксперимент проводили в Южной Корее, когда потерявшей дочь матери устроили «встречу» с виртуальным аватаром ребёнка. Возможно, эта процедура стала для этой женщины ещё одним элементом переживания утраты. Вопрос в том, ослабит это боль утраты или, напротив, усилит? Это очень индивидуально. Плюс, нужно учитывать культурные особенности — например, в Корее совсем другие траурные традиции, чем в России. Конфуцианская традиция подразумевает активное «общение» с духами покойных родственников, чего у нас нет. И новые технологии часто просто предлагают какие-то аналоги уже имеющихся в культурной традиции проявлений. Поэтому с этической точки зрения, прежде всего, такие вещи должны создаваться индивидуально под конкретных людей, а не просто для развлечения.

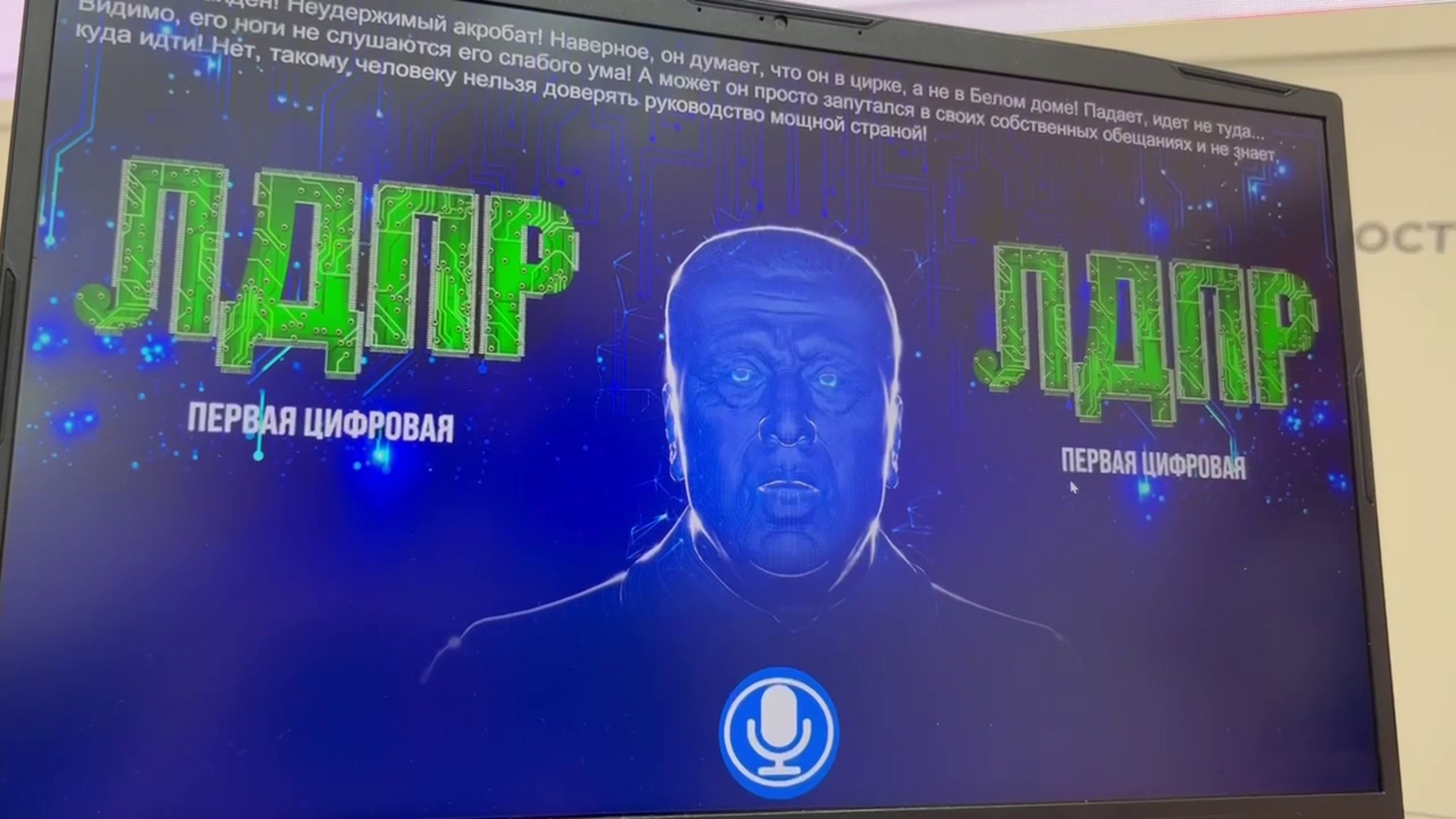

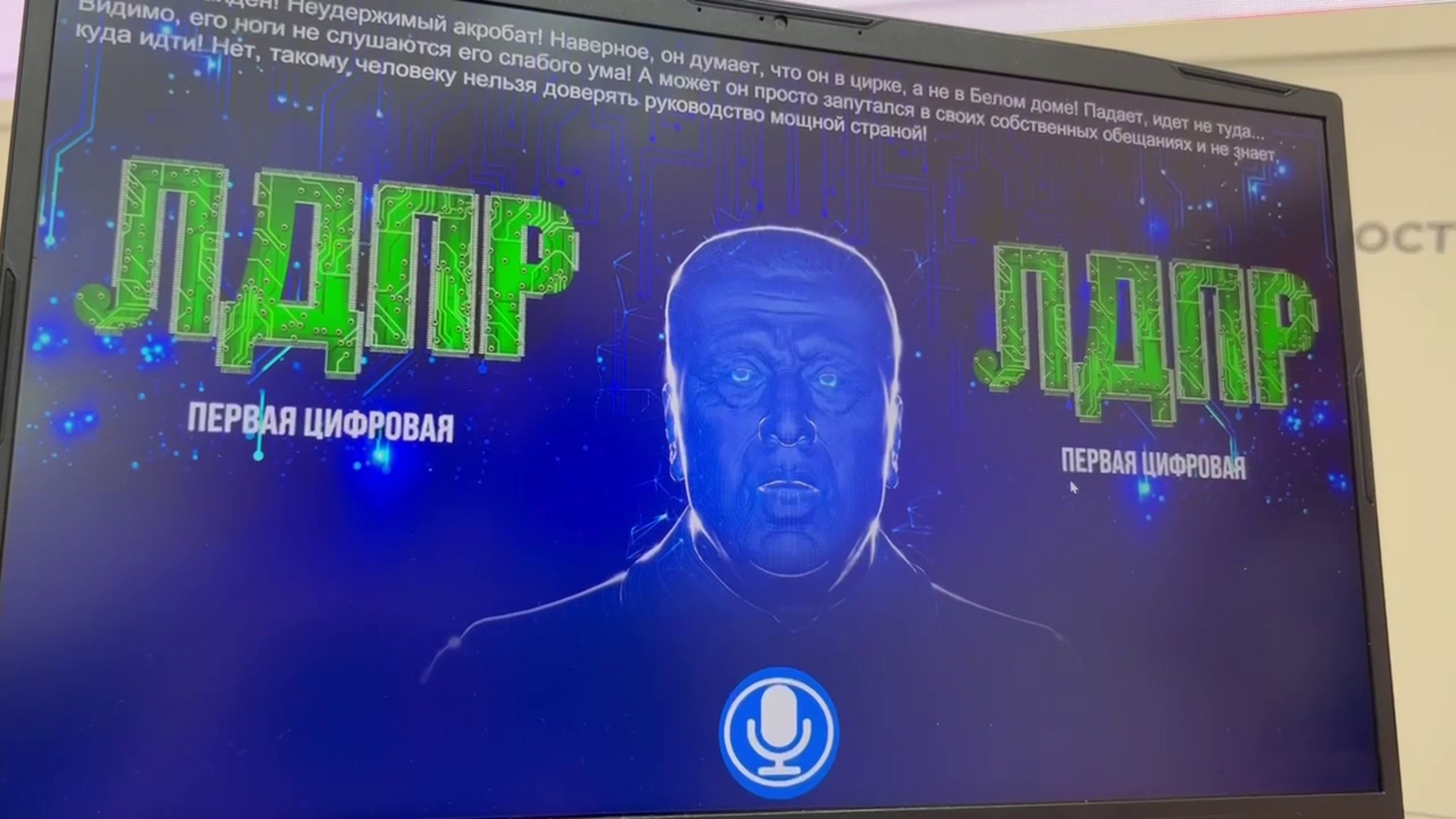

Цифровой аватар Владимира Жириновского РИА Новости

При бездумном массовом внедрении мы рискуем столкнуться с тем, что вместо психологической помощи у части людей такие технологии будут вызывать зависимость, человеку будет сложно вернуться к реальности, где его близкого уже нет.— Феномен антропоморфизации нейросетей людьми, появился давно — такие эмоции вызывала ещё созданная в 1966 году программа «Элиза», которая была предназначена для психотерапии. Какие социальные последствия может иметь такое очеловечивание нейросетей?

— Дело в том, что пока даже специалисты не смогли договориться, что же такое сознание и разум — ни психологи, ни философы. Поэтому люди руководствуются в этом вопросе бытовыми представлениями — если программа рисует и пишет подобно человеку, то, значит, она на него похожа. В 2013 году на эту тему вышел хороший фильм «Она», где главный герой полюбил операционную систему, искусственный интеллект, который «общался» женским голосом.

Это хорошая иллюстрация того, как люди могут впасть в зависимость от ИИ. Тем более, что все коммерческие продукты создаются с расчётом на то, чтобы пользователи проводили с ними как можно больше времени. В современном мире идёт ожесточённая борьба за внимание людей, чем дольше вы сидите в определённой соцсети, тем больше рекламы она может вам показать и заработать. И когда создаются антропоморфные машины, которые имитируют человеческие проявления, нам трудно сопротивляться — так устроена наша психика. Такие программные продукты вызывают у человека ложное чувство замены традиционных социальных связей. Однако пока мы это отслеживаем, а смогут ли отслеживать границу между суррогатной и реальной социализацией новые поколения — это вопрос.

— Говоря об ИИ, сложно не затронуть тему вооружений: нейросети всё активней применяются в ударных дронах и других видах оружия всеми странами. Какие этические проблемы есть в связи с этим?

— Самая обсуждаемая в этом контексте тема — беспилотные летальные вооружения, именно это вызывает наибольшие опасения. Это не просто автоматизация действий, которыми управляет человек. Это ситуация, когда автономные устройства не зависят от человека в выборе цели и сами принимают решение о нанесении удара, что ставит очень много серьёзных вопросов. Очень важно, чтобы появилось правовое регулирование этой области. При правильном применении автономные вооружения могли бы минимизировать число жертв среди участников конфликта и мирного населения, так что это тоже медаль с двумя сторонами. Есть позиция, согласно которой мы не должны исключать человека из процедур принятия моральных решений, а нанесение удара — это как раз моральный выбор. На мой взгляд, в отношении такого оружия всё же должна возобладать запретительная правовая тенденция.

Социальные сети Gettyimages.ru © SDI Productions

— Как соблюсти баланс между личными правами граждан и развитием IT-индустрии? И есть ли вообще такое противоречие, или это надуманный аргумент?— Как и в случае многих других технологий, с ИИ нам нужно суметь пройти между Сциллой и Харибдой. Чтобы, с одной стороны, чрезмерным контролем и бюрократией не затормозить исследования в этой области. А с другой — минимизировать риски, которые влечёт бесконтрольное внедрение некоторых технологий. В этом и заключается цель и смысл правового и этического регулирования. Те примеры, которые мы с вами разобрали, говорят о том, что вряд ли возможно выработать универсальные правила для всей цифровой отрасли, без учёта конкретной специфики. В каждом конкретном случае необходима тщательная этическая экспертиза, как это уже работает в области биомедицинских исследований. Каждое медицинское исследование получает одобрение этического комитета учебного учреждения, в случае с ИИ нам нужно выстроить похожий механизм социально-гуманитарной экспертизы.

Читайте также

«Новые горизонты перед наукой»: российский учёный — о применении нейросетей для анализа фотографий диких животных

Наука и техника

Технологии искусственного интеллекта находят применение в зоологии и биологии — например, для точного отслеживания численности и миграций популяций диких животных, а также учёта редких видов. Нейросети, обученные на массивах ранее собранных данных, способны индивидуально идентифицировать особей животных в природной среде. Об этом в интервью RT рассказал доцент кафедры радиоэлектроники и прикладной информатики ФРКТ МФТИ кандидат технических наук Андрей Леус. По словам учёного, нейросети также

Академик РАН Тыртышников: свои исследования я определяю как "борьбу с суперкомпьютерами"

Наука и техника

12 декабря 2023 года трем выдающимся российским ученым была вручена научная премия Сбера. О потенциальных направлениях развития суперкомпьютеров, выдающейся отечественной математической школе и взаимодействии с международным научным сообществом ТАСС поговорил с одним из лауреатов премии, директором ФГБУН "Институт вычислительной математики им. Г.И. Марчука", академиком Российской академии наук Евгением Тыртышниковым. — Расскажите о своей научной работе, отмеченной премией. В чем ее

Академик РАН Анаников: за фотокатализом будущее каталитических технологий

Наука и техника

Трем выдающимся российским ученым 12 декабря 2023 года вручили научную премию Сбера. О применении алгоритмов искусственного интеллекта (ИИ) для создания промышленных технологий нового поколения, важности научных грантов для проведения исследований и преимуществах фотокатализа в производстве препаратов ТАСС поговорил с одним из лауреатов премии, академиком Российской академии наук, заведующим лабораторией Института органической химии им. Н.Д. Зелинского РАН Валентином Ананиковым. — Расскажите о

Комментарии (0)